La ciberseguridad “clásica” ya no basta cuando utilizas Inteligencia Artificial (IA) en procesos críticos. El Reglamento Europeo de Inteligencia Artificial exige, para sistemas de alto riesgo, un nivel adecuado y consistente de ciberseguridad durante todo el ciclo de vida, y medidas contra ataques específicos: envenenamiento de datos, ataques adversarios, extracción/inversión y explotación de defectos del sistema.

Vamos a fundamentar nuestro estudio en la Guía número 11. Ciberseguridad de la Agencia Española de Supervisión de la Inteligencia Artificial (AESIA) que se enfoca en el cumplimiento del artículo 15 del Reglamento Europeo de Inteligencia Artificial (RIA): Reglamento (UE) 2024/1689 del Parlamento Europeo y del Consejo, de 13 de junio de 2024, por el que se establecen normas armonizadas en materia de inteligencia artificial.

Por qué IA y ciberseguridad deben ir juntas

La cuestión es clara, y desde nuestro punto de vista, obvia: en sistemas de IA (especialmente de alto riesgo) la ciberseguridad no puede ser opcional porque hay amenazas específicas capaces de manipular datos, forzar errores, extraer información o aprovechar fallos del modelo o su integración. Todo eso puede acabar en daños reales: privacidad, discriminación, limitación de derechos, daños materiales o a la salud.

Por ello, el artículo 15 del RIA pide dos cosas clave:

- Consistencia de la ciberseguridad durante todo el ciclo de vida.

- Resistencia frente a intentos de terceros de alterar uso, resultados o funcionamiento explotando vulnerabilidades.

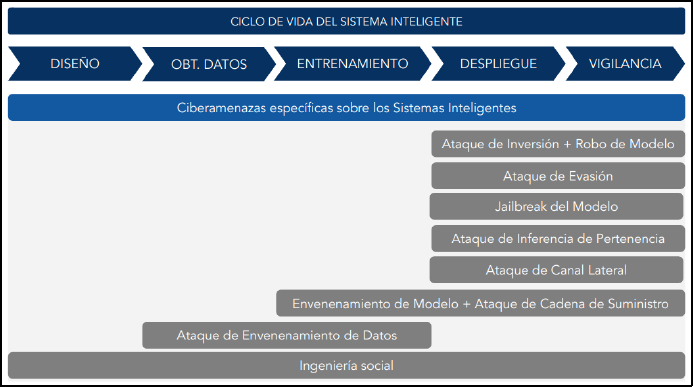

El mapa real de amenazas

La guía agrupa una serie de amenazas típicas para IA:

- Envenenamiento (de datos o del propio modelo) para insertar comportamientos maliciosos o “puertas traseras”.

- Evasión: entradas diseñadas para que el modelo se equivoque en producción.

- Inversión y extracción: obtener información de datos de entrenamiento o replicar el modelo a base de consultas.

- Canal lateral, cadena de suministro (dependencias, librerías, hardware) y DoS específicos para IA (consultas que agotan recursos).

La idea clave es que las amenazas aparecen en distintos momentos del ciclo de vida según consta en el siguiente esquema por fases:

Coordinar IA + ciberseguridad en la empresa: un plan operativo en 6 pasos.

Paso 1. Gobernanza: quién decide y quién responde.

Se recomienda:

- Planificar el nivel de ciberseguridad para IA desde diseño y desarrollo.

- Involucrar al DPD (Delegado de Protección de Datos) desde el diseño y en decisiones de ciberseguridad cuando haya impacto en datos personales.

- Definir responsables y un cuadro de mando (dashboard) con indicadores, y fijar periodicidad mínima de auditorías internas/externas.

Paso 2. Inventario de activos y actores.

Lo que no se inventaría no se protege. El planteamiento que sirve como base es el siguiente: identificar activos (datos, modelo, procesos, entornos, artefactos) y actores (roles internos/externos), asociarlos y montar un modelo de amenazas, con preferencia a un enfoque RACI (Responsable-Aprobador-Consultado-Informado) para disponer de una gestión organizativa que asigne roles y responsabilidades, asegurando así que cada tarea tenga un dueño claro y personas de apoyo definidas.

Paso 3. Control de accesos robusto.

La primera línea de defensa son las políticas de acceso con las siguientes recomendaciones:

- RBAC (Role-Based Access Control – control de acceso basado en roles): Es un modelo donde los permisos no se dan persona a persona, sino por funciones. Por ejemplo, un científico de datos puede entrenar el modelo, pero un desarrollador solo puede consultarlo.

- Mínimos privilegios: Es la regla de oro de la seguridad que dicta que cada usuario o proceso debe tener únicamente los permisos mínimos indispensables para realizar su tarea

- Autenticación robusta: priorizar métodos que se basen en protocolos avanzados como certificados digitales

- MFA (Multi-Factor Authentication – autenticación de múltiples factores) con el uso de dos o más evidencias independientes para verificar la identidad el usuario (algo que sabes: contraseña, algo que tienes: token físico, algo que eres: biometría).

- Registro y auditoría de accesos: monitoreo y almacenamiento de interacciones con el sistema (quién, cuándo, desde dónde y a qué recursos accedió) por ejemplo para rastrear si alguien manipuló los parámetros de entrenamiento.

- Revocación inmediata por baja del personal: proceso de dar de baja todas las credenciales y permisos de un usuario en el mismo instante en que deja de formar parte de la organización o del proyecto.

Paso 4. Proteger los datos para evitar el “envenenamiento”.

El envenenamiento ocurre cuando se introducen datos falsos para que la IA aprenda mal a propósito. Para evitarlo, contamos con estas defensas:

- Control de versiones: Es el historial de los datos. Permite saber qué entró, quién lo puso y volver atrás si detectamos información corrupta.

- Cifrado: Blindar los datos con cifrados, tanto en reposo como en tránsito, para evitar la alteración no deseada de información.

- DLP (Data Loss Prevention – Prevención de pérdida de datos): Es necesario un filtro que evita que datos sensibles (como datos personales o secretos de empresa) se mezclen o se filtren donde no deben, por ejemplo entrenando al modelo con datos reales de forma accidental, teniendo que identificar, monitorizar y bloquear dicha información.

- Detección de anomalías (Outliers): Un sistema que identifica y descarta datos «extraños» o exagerados que no encajan con la realidad y que podrían confundir a la IA, estableciendo filtros de calidad, para detectar, aislar y eliminar lo que posiblemente sea un error o un ataque.

- Identificación de envenenamiento: Pruebas constantes para verificar que la IA sigue siendo coherente y no ha sido manipulada tras recibir nueva información.

Paso 5. Proteger el modelo en producción: ataques adversarios, extracción e inversión.

Establecer controles según el riesgo y la finalidad:

- Evitar modelos “demasiado conocidos o comunes” personalizando o protegiendo sus detalles técnicos para evitar que sean un blanco predecible.

- Detección de entradas anómalas o fuera de lugar (Out of Distribution – OoD) para configurar umbrales de confianza y alertas, entrenando al modelo para que alerte en lugar de inventar o fallar.

- Límites por origen (IP/usuario/dispositivo) y bloqueo o ralentización ante patrones sospechosos.

- Medidas de privacidad y técnicas para mitigar inferencias sobre datos de entrenamiento, con técnicas para que nadie pueda interrogar astutamente a la IA para sonsacarle información privada.

Paso 6. Cerrar el círculo: integración, configuración, terceros y auditorías.

Los incidentes o los fallos en la IA puede que surjan en las herramientas que se emplean para su uso, por ello es necesario:

- Vigilar las piezas externas (Frameworks y Dependencias): Los sistemas de IA usan «librerías» o piezas de software creadas por terceros. Si una de esas piezas tiene un fallo de seguridad conocido (CVE Common Vulnerabilities and Exposures, que es un catálogo público de fallos de seguridad conocidos) la IA también estará en peligro.

- Revisiones automáticas: No basta con revisar una vez. Hay que usar herramientas que escaneen automáticamente estas piezas en busca de debilidades (CWE Common Weakness Enumeration – enumeración de debilidades comunes) para arreglarlas antes de que un atacante las aproveche.

- Control de entornos: Separar bien dónde se diseña, dónde se prueba y dónde se usa la IA (desarrollo, test y producción) para que un error en las pruebas no deje expuesto el sistema real.

- Análisis y pruebas periódicas con pentesting orientado a IA, disponiendo de indicadores y estableciendo umbrales para detectar degradación, fallos o compromisos.

- Contratos con terceros con cláusulas de auditoría, certificaciones, remediación y respuesta a incidentes.

- Auditorias, que aportan revisiones periódicas realizadas por expertos (internos o externos) que verifican que todos los controles anteriores funcionan realmente.

¿Y si no soy proveedor, sino quien despliega la IA en mi empresa?

Existen responsabilidades tanto del proveedor como del responsable del despliegue, dependiendo del modelo (SaaS, on-premise, in-cloud gestionado por el cliente, etc.). Para la empresa usuaria, lo mínimo es:

- Entender manuales/instrucciones y aplicar controles bajo su responsabilidad (accesos, configuración, operación, formación interna). Cada modelo de IA (ya sea en la nube como SaaS o instalado en servidores propios on-premise) tiene configuraciones de seguridad específicas. Es responsabilidad de la empresa configurar correctamente los muros de acceso, definir quién puede ver qué y formar al personal para que no use la IA de forma imprudente (por ejemplo, compartiendo secretos comerciales en un chat abierto).

- Integrar roles y sustituciones para que el sistema no dependa de “una sola persona”. Un sistema crítico de IA no puede ser una «caja negra» que solo una persona en toda la empresa sabe manejar. Es vital definir roles claros y tener protocolos de sustitución. Si el responsable técnico se va o no está disponible, la empresa debe poder seguir operando, auditando y, si fuera necesario, apagando o bloqueando el sistema sin perder el control.

- Tambiés en necesaria una operación y supervisión continua: Desplegar una IA no es «instalar y olvidar». La empresa debe vigilar cómo se comporta el sistema en su entorno real, asegurándose de que la configuración inicial no se degrade y que los permisos de los empleados estén siempre actualizados (revocando accesos si alguien cambia de departamento).

Perspectiva usuario: cómo usar IA con más seguridad

Los hábitos del usuario son la última línea de defensa. La seguridad de la IA también depende de cómo el usuario interactúa con ella. Estas son las reglas básicas a seguir:

- Privacidad : El usuario no debe compartir datos sensibles (salud, finanzas, secretos de empresa, etc.) por lo que no ha de emplearlos en el modelo de IA que utilice.

- Proteger la cuenta: El acceso ha de contar con una contraseña robusta y, sobre todo, teniendo activo el MFA (por ejemplo doble factor de autenticación). Si un atacante tomara el control de una cuenta de IA, podría acceder a todo el historial de consultas y documentos.

- Sentido común ante anomalías: El usuario ha de desconfiar si la IA pide «cosas raras», como subir archivos sospechosos para «funcionar mejor» o saltarte pasos de seguridad. Un sistema manipulado puede intentar engañar al usuario para que proporcione información.

- Respeta las alertas del sistema: Si la herramienta muestra un aviso de «baja confianza» o una alerta de seguridad, el usuario no debe ignorarla sino reportarla.

- Cumplir con las reglas de la organización : El usuario solamente debe usar las herramientas de IA autorizadas por la organización. El «Shadow AI» (IA oculta: que usuario use IAs por su cuenta sin que lo sepa la organización) es uno de los mayores riesgos en el uso de IA hoy en día.

Checklist para coordinar IA + ciberseguridad

Este sería un breve checklist para un despliegue seguro de IA en una organización:

- Gobernanza y estrategia: Realizar un inventario de IAs que se emplean y quiénes las utilizan. Definir una matriz RACI (quién es Responsable, quién Aprueba, quién es Consultado y quién Informado) para que no haya dudas sobre quién manda en cada proceso.

- Accesos blindados: Aplica el control por roles (RBAC) exigir el MFA para entrar y asegurarse de guardar registros (logs) de cada movimiento.

- Datos bajo control: Vigilar los datos que se proporcionan a la IA. Activa filtros (DLP) para que la información sensible no sea objeto de fugas.

- Modelo Vigilado: Poner límites de uso para evitar abusos. Configurar alertas que detecten preguntas fuera de lugar (OoD) y monitorizar las respuestas para que la IA no se vuelva inestable o sea inseguro su uso.

- Entorno seguro: Separar los entornos de prueba de los de producción. Revisar las piezas externas (librerías) constantemente para comprobar que sean seguros.

- Cultura y formación: De nada sirve la tecnología si el equipo no sabe usarla: realizar formación específica para los usuarios para que sepan detectar un ataque de envenenamiento o un intento de manipulación de la IA.

Solicita presupuesto sin compromiso

En LEGALIA ayudamos a coordinar el uso de la IA con la protección de datos y la ciberseguridad con un enfoque práctico: análisis de riesgos, políticas de uso, contratos con proveedores, y plan de cumplimiento alineado con el Reglamento Europeo de IA. Si tu empresa ya usa IA (o va a implantarla), revisamos tu escenario y te proponemos un plan de medidas y documentación.